|

5eme journée interaction humain-machine et intelligence artificiellecomprendre, décider, collaborer: comment IA et IHM se complètent11 mars 2021 · 10h-17h · conférence en ligne |

| H | TITRE & RÉSUMÉ | INTERVENANTS |

|---|---|---|

| 10h | Présentation de l’AFIA et de l’AFIHM

L'Association Française d'Intelligence Artificielle (AFIA) promeut et favorise le développement de l’Intelligence Artificielle sous ses différentes formes, regroupe et fait croître la communauté française en IA, et en assure la visibilité. L'Association Francophone d'Interaction Homme-Machine (AFIHM) promeut le savoir et les connaissances du domaine de l'Interaction Homme-Machine et les divers domaines concourants au savoir et aux connaissances facilitant la conception, la réalisation et l'évaluation des systèmes interactifs actuels et futurs. |

Yves Demazeau (AFIA) et Éric Lecolinet (AFIHM)

Yves Demazeau a été président de l'AFIA de 2011 à 2020. Il est directeur de recherche au CNRS, rattaché au Laboratoire d'Informatique de Grenoble (LIG). Il est aussi professeur invité à l'université du sud Danemark. Eric Lecolinet est président de l'AFIHM depuis 2017. Il est professeur à l'institut Polytechnique de Paris (Telecom Paris) et responsable de l'équipe de recherche DIVA (Design, Interaction, Visualisation & Applications). |

| 10h15 | Coadaptation humain-machine : qui fait le premier pas? L’apprentissage machine et l’intelligence artificielle sont maintenant omniprésents dans les applications et systèmes faisant face à des utilisateurs humains. Nous les retrouvons dans les applications émulant des tâches cognitives comme la parole ou la reconnaissance d’objets, mais aussi dans des systèmes de recommendation de contenu ou d’aide à la décision. Le changement de paradigme amené par ces méthodes est leur capacité à s’adapter aux utilisateurs, par l’intermédiaire de données personnelles et collectives. De manière réciproque, l’utilisateur de ces applications vont eux-mêmes s’adapter aux changements induits par ces méthodes adaptatives. Cette co-adaptation est alors au centre des nouvelles interactions humain-machine. Dans cet échange nous commencerons par présenter des exemples de travaux illustrant la co-adaptation dans les IHMs, le milieu artistique et médical. Nous discuterons des méthodes mis en jeu et amèneront la discussion vers des enjeux socio-culturels telles que la confiance et les négociations dans ces co-adaptations. |

Stéphane Canu et Baptiste Caramiaux

Stéphane Canu est professeur à l'INSA de Rouen, Chargé de mission "Intelligence Artificielle au ministère de l'enseignement supérieur, de l'innovation et de la recherche. Baptiste Caramiaux est chargé de recherche au CNRS, membre de l'équipe Sorbonne HCI. |

| 11h15 | posters et discussions | |

| 11h30 | Apports de l’IA et de l’IHM pour soutenir l’apprentissage en contexte éducatif: Émergence de nouveaux possibles Les travaux relatifs à l’apprentissage humain exploitent et enrichissent les travaux en IA depuis l’avènement de celle-ci. L’IA a ainsi permis de modéliser les connaissances du domaine à enseigner, de l’apprenant, des interactions possibles mais a également permis de raisonner sur ces connaissances. Les travaux sur l’apprentissage humain ont enrichi l’IA en apportant de nouveaux défis : adaptation aux raisonnements de chaque individu et non plus d’un expert, prise en compte de la motivation, des émotions, etc. De même, les travaux en IHM ont permis l’émergence de nouvelles générations d’interfaces. Alternatifs aux environnements s’appuyant sur l’usage d’un clavier, d’un écran et d’un outil de pointage (souris, doigt, stylet etc.…), mixant les technologies (réalité mixte, interfaces tangibles, textiles, physiologiques, etc.) et les approches (technologies positives, environnements numériques ludifiés, environnements collaboratifs, réflexifs et affectifs, etc.,). Ils redéfinissent les possibles des technologies pouvant soutenir l’apprentissage humain et les contours de l’école de demain.. Un des défis actuels concerne les traces d’interaction entre les systèmes support à l’apprentissage et leurs acteurs. Il faut être capable d’acquérir des traces riches et diverses mais également de les analyser, de les exploiter pour fournir une aide à tous les acteurs (apprenants, enseignants, familles…) en restituant ces traces de manière intelligible et en proposant les résultats de leurs exploitations de manière acceptable et donc justifiables. |

Échange entre Marie Lefevre et

Stéphanie Fleck

Marie Lefevre est maitre de conférence dans l'équipe TWEAK du LIRIS, membre des CA de l'ATIEF et de l'AFIA, et co-responsable du groupe de travail "Adaptation et génération des activités proposées dans les EIAH" de l'ATIEF. Stéphanie Fleck est maitre de conférence à l'université de Lorraine, membre de l'équipe Perseus, et animatrice du groupe de travail EduIHM de l'AFIHM. |

| 12h30 | pause repas et salon des posters | |

| 14h | Analyser, comprendre le monde : Complémentarité entre apprentissage et visualisation (presentation 1) (presentation 2) L'apprentissage (ML) a conduit à des succès indiscutables dans de très nombreux domaines qui étaient réservés aux humains il y a encore vingt ans : les moteurs de recherche sur le web, les jeux d'échecs, de Go ou de poker, les recommandations sur les sites marchands, la finance à haute fréquence, et un grand nombre d'avancées médicales, scientifiques et techniques. En miroir, l'interaction humain machine (IHM) est au coeur du succès des outils utilisés par le grand public et des outils connectés (téléphones mobiles, montres, ...) ; son plus grand succès est d'être invisible, et seuls ses échecs sont remarqués. L'IHM constitue ainsi un aspect majeur des moteurs de recherche ou de recommandation. L'interaction entre ML et IHM présente des difficultés spécifiques. Les IHM-iens ont longtemps vu le ML comme le tristement célèbre trombone de Word. Symétriquement, les ML-eurs peinent à comprendre l'IHM : qu'est-ce qu'on optimise ? quels sont les indicateurs de performance ? Le fait d'inscrire IHM et ML dans le cadre des activités humaines permet de dénouer ce dilemme. Un exemple sera présenté dans le cadre de l'exploration de collections de millions de documents à l'aide d'IA et d'IHM avancées à vocation humaniste : Cartolabe. Collaboration: Philippe Caillou, Anne-Catherine Letournel, Jonas Renault. |

Jean-Daniel Fekete et

Michèle Sebag

Jean-Daniel Fekete, directeur de recherche Inria, Université Paris-Saclay, spécialiste de la visualisation et de l'IHM, s'intéresse au passage à l'échelle, à la visualisation analytique qui combine IA, IHM et visualisation, et aux applications pour les sciences humaines et sociales, et les sciences en général. Michele Sebag, directrice de recherche au CNRS, Université Paris-Saclay, membre de l'académie des technologies, spécialiste d'apprentissage, s'intéresse à la modélisation causale et aux applications du ML pour les sciences humaines et sociales, et pour l'épidémiologie. |

| 15h | Le projet AIDA et IBM Research à Saclay : IA et facteurs humains dans les opérations des entreprises. Le projet AIDA (pour Artificial Intelligence & Decision Automation) est né d'une synergie entre les activités du laboratoire français d'IBM, pionnier de l'ingéniérie de la décision, et des ressources d'entreprises et de centres de recherches français, magnifiées par le développement du plateau de Saclay. Nous présenterons la vision du projet qui vise à fournir une nouvelle génération de produits d'automation de l'entreprise, exploitant les avancées récentes de l'intelligence artificielle, mais prenant en compte également le besoin profond de nos sociétés de savoir garder la maitrise, la transparence et l'équité de ces systèmes. |

Christian de Sainte-Marie

Christian de Sainte-Marie est Directeur du Centre des Études Avancées d’IBM France Lab, il est l'architecte du projet AIDA et de la création du laboratoire d'IBM Recherche à Saclay. |

| 15h15 | posters et discussions | |

| 15h30 | Complémentarité de l'IA et l'IHM : l’exemple de CausalityLink Pierre Haren a co-fondé ILOG dans les années 80 pour commercialiser les travaux d'Inria sur la première génération d'intelligence artificielle, mais aussi les premiers générateurs d'interfaces graphiques. Avec un succès retentissant, puisqu'ILOG fût une des premières entreprises françaises cotées au NASDAQ, reposant sur une gamme de produits où l'offre de visualisation (Views) complétait harmonieusement l'offre IA (JRules, CPLEX...). Aujourd'hui, avec CausalityLink, c'est un nouveau défi qu'il aborde: permettre aux analystes financiers de donner du sens aux flots d'information pertinente qu'ils doivent maitriser. Et encore une fois, c'est en se reposant sur des outils d’IA pour traduire et interpréter automatiquement des millions de textes, mais aussi des outils de visualisation et d'exploration de graphes, que CausalityLink entreprend de répondre aux défis du déluge d'information auquel nos sociétés doivent donner du sens, en ouvrant la voie de l’intelligence collective soutenue par l’IA. Avec Nicolas Roussel, chercheur en IHM avec un intérêt particulier pour l’IA, ils proposeront des pistes de réflexion autour des liens entre recherche et innovation et de la complémentarité entre IHM et IA. |

Pierre Haren interviewé par

Nicolas Roussel

Pierre Haren a co-fondé ILOG dans les années 80 et l'a dirigé jusqu'à son rachat par IBM en 2009. Il est maintenant PDG de CausalityLink, aux Etats-Unis. Nicolas Roussel est directeur de recherche INRIA et directeur d'Inria Sud-Ouest. |

| 16h30 | Conclusions

Thomas Baudel proposera un argument métaphysique sur la complémentarité de l'IA et de l'IHM, Benoit Le Blanc proposera une synthèse de la journée et nous discuterons avec le public des opportunités ouvertes par cette journée. |

Benoit Le Blanc

et Thomas Baudel

Benoit Le Blanc est directeur de l'ENSC et président de l'AFIA depuis 2021. Thomas Baudel est directeur de Recherche au Laboratoire Français d'IBM "Decision Engineering Lab" et membre du conseil d'administration de l'AFIHM à intervalles réguliers depuis 1998. |

| POSTER | TITRE & RÉSUMÉ | AUTEURS & BIOS |

|---|---|---|

|

Concevoir des machines «intelligentes» pour soutenir durablement l’activité humaine

L’engouement pour l’IA est tel qu’une myriade de machines « intelligentes » voit le jour à toutes les strates de la société. Elles auraient la capacité d’apprendre au gré de leurs expériences et donc de pouvoir évoluer afin de répondre de manière toujours plus adaptée aux situations de vie, anticipant même le comportement des usagers et usagères. En interrogeant les modèles de l’activité massivement mobilisés aujourd’hui dans la conception de machines « intelligentes », notre travail propose de déplacer le dessein de « l’humain augmenté » vers celui d’une aide à l’activité humaine, d’une augmentation de ses pouvoirs d’agir. Derrière les discours prophétiques autour de l’IA, nous questionnons ainsi l’activité réelle qui se cache derrière son bon fonctionnement. Le caractère « intelligent » n’est-il finalement pas le fait de l’humain qui façonne la machine, la reconstruit, la réinvente ? Pour y répondre, notre travail de recherche articule deux études. D’une part, il s’agit d’analyser une situation existante (les effets de l’introduction de chatbots sur des systèmes sociotechniques professionnels) ; d’autre part, il s’agit d’intervenir en amont de la conception de dispositifs destinés au contexte domestique et de définir, à partir d’une analyse de l’activité réelle et des besoins, puis d’une simulation de l’activité outillée par des dispositifs futurs possibles, quels services réellement pertinents (du point de vue humain) peuvent être conçus. Cette vidéo constitue une vulgarisation scientifique de notre recherche et propose d’exposer en trois minutes chrono les principaux défis de notre travail. |

Marion Gras Gentiletti Après des études en linguistique et informatique appliquées aux sciences sociales, je finalise actuellement une thèse de doctorat en Ergonomie au sein de l’entreprise EDF R&D et de l’Université Paris 8 (Laboratoire Paragraphe). Cette thèse est en cours de finalisation et a contribué à deux projets de conception (services autonomes pour l’habitat et chatbot pour des situations professionnelles). |

|

La revanche des Défis Sith, ou l'IA pour l'accessibilité des IHM

Afin de rétablir l’équilibre dans la force au sein de la galaxie, le sénat intergalactique a confié à deux Jedis la mission de mettre en place un dispositif d’interaction permettant à un environnement informatique d’interagir avec les différentes espèces, en dépassant les contraintes d’usage singulières à chaque espèce. Les deux Jedis proposent une Intelligence Artificielle baptisée Leia ou « Lisibilité malgré l’éclectisme grâce à l’I.A./interaction augmentée ». Grâce à trois espaces (production-coordination-communication) et trois niveaux de représentation (environnement- agents - organisation) issues des modèles OrA, JaCaMo et Clover, la paix est maintenue lors d'un concours de cuisine entre Yoda et Vador. C’est cette épopée apocryphe que vous allez découvrir. Version longue de la vidéo.

Lauren Thevin. Un système-multi agent normatif pour le soutien évaluatif à la collaboration humain-machine: application à la gestion de crise. 2016. Thèse de doctorat. |

Alexis Audic et Lauren Thévin

Alexis Audic est étudiant en Master 2 Informatique, Communication numérique et conception multimédia à l'UCO-BS. Il fait un stage en domotique et en accessibilité pour les personnes avec déficiences visuelles avec la plateforme M@D (maintien à domicile) basée à Lorient. Lauren Thévin est maitresse de conférence en informatique à l'UCO. Elle a une thèse sur les systèmes multi-agents pour l'interaction humain-machine dédié à l'entrainement des communes à la gestion de crise (par exemple, lors d'une inondation), réalisé à l'UGA (LIG, équipes AMA et Magma) et avec l'Ecole des Mines de Saint Etienne (ISCOD). Elle s'est par la suite tournée vers la réalité virtuelle/augmentée accessible avec déficience visuelle chez Inria (Potioc), à l'IRIT (Elipse/Cherchons pour voir), puis au LMU (HCUM Team). |

|

Outil d'évaluation des risques de chute: scénario de réalité virtuelle

La chute est la première cause d'accident chez les personnes âgées. Chaque année, elle concerne 1 personne sur 4 chez les plus de 65 ans. Le risque de chute est multifactoriel : ses causes peuvent notamment être motrices, attentionnelles ou cognitives. Afin de mieux caractériser, comprendre et prédire ce risque de chute, nous souhaitons proposer au praticiens une solution technologique fondée sur la réalité virtuelle, permettant de collecter et d’identifier différents indicateurs du risque de chute. Cette solution se veut simple d’utilisation pour le praticien, automatisant le protocole expérimental et la collecte d’indicateurs et assurant la reproductibilité des conditions de l'expérimentation. Notre outil est compatible avec des dispositifs de réalité virtuelle grand public : le patient est équipé d’un casque de réalité virtuelle, 2 contrôleurs, et 3 trackers supplémentaires placés aux pieds et à la ceinture. Ces équipements permettent une capture cinématique du corps complet, restituée en temps réel au patient sous la forme d’un avatar par un algorithme de cinématique inverse. Ces données cinématiques sont également mise à disposition, d’une part, au praticien pour un replay de l’expérience ; et d’autre part, pour le processus d’apprentissage numérique. L’expérimentation consiste à placer le patient dans 6 situations de tests inspirées de la vie quotidienne, introduisant progressivement différentes tâches et obstacles testant ses capacités motrices, attentionnelles et cognitives. De nombreux indicateurs de performance sont collectés (temps, précision d’exécution de la tâche, etc.) afin d’alimenter le processus d’apprentissage numérique. L’introduction progressive de nouvelles tâches dans les tests permet une comparaison inter-patient et inter-test afin de mieux identifier les facteurs pouvant mettre en difficulté le patient. |

Gabin Personeni,

Fabien Clanché, Thierry Bastogne et Gérôme Gauchard

Gabin Personeni, Docteur en informatique, est ingénieur de recherche à l’Université de Lorraine. Il s’intéresse à la métrologie et IA pour la santé. |

|

Dialogue adaptatif pour l'assistance cognitive dans un système d’aide à domicile

La réadaptation cognitive a démontré que l'assistance verbale permet d’accroître l'indépendance et la participation active des personnes sujettes aux troubles cognitifs dans l’accomplissement des activités quotidiennes. L'assistance cognitive est généralement fournie par le biais d'un dialogue où la personne aidante donne des indications verbales auxquelles la personne assistée répond par son comportement. En raison du coût et de l'indisponibilité des personnes aidantes pour fournir une assistance 24h/24 et 7j/7 aux personnes souffrant de déficits cognitifs, les systèmes d'aide à domicile (SAD) offrent une alternative prometteuse. Cependant, il existe un risque que l'assistance automatisée soit excessive ou insuffisante et qu'elle ne s'adapte pas aux utilisateurs. En effet, la réadaptation cognitive prône le « renforcement » des utilisateurs en leur fournissant le juste niveau d'assistance qui les pousse à agir par eux-mêmes. Notre objectif est de construire un dialogue d'assistance cognitive adaptatif pour les SAD. Ce dialogue repose sur quatre piliers. La réadaptation cognitive et les données probantes permettent d'aligner l’aide automatisée sur les pratiques de réadaptation en soins de santé. Les actes de langage fournissent des outils pour mieux comprendre le fonctionnement du dialogue d'assistance cognitive, la manière dont les contenus des messages d'assistance et les actions des personnes assistées sont liés, et pour grader le niveau d'information nécessaire pour pousser la personne à agir de façon indépendante. Une ontologie formalise la connaissance et la sémantique du dialogue d'assistance dans un format exploitable par une machine. Enfin, un « Behaviour Tree » sélectionne dynamiquement les messages et les effecteurs adéquats pour les diffuser et évalue les réactions des utilisateurs pour une prise de décision ultérieure (i.e., arrêter le dialogue ou continuer en adaptant l’assistance). Le résultat est un dialogue d'assistance cognitive qui s’aligne sur la réadaptation cognitive et la pratique clinique dans le respect des forces et difficultés de la personne aidée. |

Armel Ayimdji Tekemetieu, Hélène Pigot, Carolina Bottari, Mireille Gagnon-Roy et Sylvain Giroux

Armel, Hélène et Sylvain: Laboratoire Domus, Université de Sherbrooke, Québec, Canada Carolina, Mireille: École de readaptation, Université de Montréal, Québec, Canada Armel: Institut Universitaire de Technologie (IUT) de Douala, Université de Douala, Cameroun Hélène, Sylvain: Centre de recherche sur le vieillissement, Sherbrooke, Québec, Canada |

|

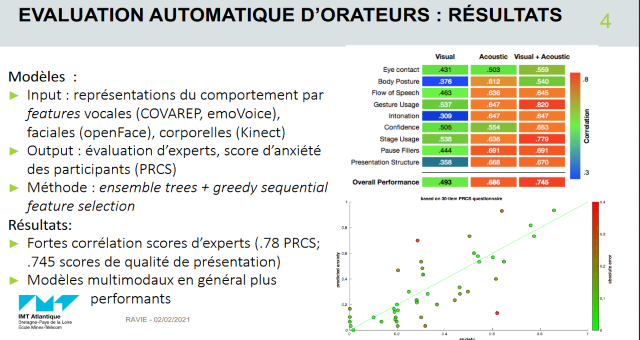

Combiner IHM et IA pour entraîner à la prise de parole en public - le projet Cicero

Les compétences sociales comme la prise de parole en public, la résolution de conflits ou l’animation de réunions, sont cruciales dans un grand nombre de professions, et sont régulièrement citées comme certaines des compétences les plus prisées par les recruteurs. Une des méthodes classiques pour l'amélioration de ces compétences consiste à suivre des formations organisées par des experts ; ces solutions ne sont malheureusement pas accessibles à tous, notamment pour des raisons de coût ou de disponibilité. Plusieurs applications informatiques commencent cependant à émerger avec l'objectif de proposer des méthodes d’entraînement en autonomie. Dans ce poster, je présente le projet Cicero, démarré à l’University of Southern California en 2013 et que je continue depuis à IMT Atlantique, dont le but est de proposer et évaluer différentes approches pour l'entraînement de la prise de parole en public. Ce projet interdisciplinaire contient des problématiques en Interaction Homme-Machine (mise en œuvre et évaluation de simulations sociales virtuelles) ainsi que des problématiques d’Intelligence Artificielle. En particulier, j'évoquerai le potentiel de modèles d’apprentissage automatique multimodal pour l’évaluation automatique de prises de parole en public (qualité de la présentation, anxiété ressentie par l’apprenant) à partir des signaux comportementaux de l'orateur détectés automatiquement (expressions faciales, gestes, prosodie). Je présenterai également les résultats d’une étude comparant les bénéfices respectifs de différents modules du système Cicero, dont un public virtuel interactif et un système de retours automatique à l’utilisateur, sur l'apprentissage et sur l'expérience utilisateur. |

Mathieu Chollet

Mathieu Chollet est Maître-Assistant en informatique à l'IMT Atlantique et membre du Laboratoire des Sciences du Numérique de Nantes (LS2N) depuis 2019. Après une thèse en informatique obtenue à Télécom Paris en 2015, il réalisa plusieurs post-doctorat au National Institute of Informatics de Tokyo, l'University of Southern California à Los Angeles, et l'Université de Glasgow. Ses domaines d'expertise incluent les interactions sociales virtuelles et le traitement du signal social par apprentissage multimodal. En particulier, Mathieu Chollet a publié des recherches sur les modèles de comportement socio-émotionnel des humains virtuels et leur impact sur les utilisateurs d'applications de formation aux compétences sociales, ainsi que sur l'évaluation automatique de la performance et de l'anxiété des orateurs publics à travers l'apprentissage machine multimodal de leur comportement. |

|

Treemap interactive pour la catégorisation d'images et de données

Avant la génération d'un modèle de classification automatique par "apprentissage supervisé", les objets doivent être étiquetés manuellement par un ou plusieurs experts du domaine. En analyse exploratoire, les étiquettes elles-mêmes n'existent pas encore, et l'expert doit d'abord définir les catégories ou groupes d'objets (taxons en biologie) similaires qui formeront ces classes, puis donner un nom/une étiquette à chacune d'elles (taxonomie). Les techniques de regroupement automatiques seules ne sont pas satisfaisantes en première approche, car la visualisation et l'interaction manuelle participent à forger la connaissance initiale de l'expert, ainsi qu’à déterminer les mesures de similarités nécessaires à ces techniques. Nous proposons une interface pour aider à la génération de ces catégories à partir de représentations graphiques signifiantes des objets initiaux. Par exemple, des patients peuvent être représentés par leur électro-cardiogramme, des entreprises par un diagramme en étoile de leurs principaux indicateurs de performance, des cellules cancéreuses par une heatmap de leur réaction à différents traitements... L'interface se base sur une carte proportionnelle (Treemap) que nous rendons interactive. Cette représentation encode graphiquement les arrangements (ordre) des objets et des groupes, les regroupements d'objets (catégories) ainsi que la taille de ces groupes. Nous montrons dans la vidéo un exemple de ces interactions à partir de peintures d'artistes qu'íl s'agit de regrouper par leur style pour les visiteurs non-experts d'un musée afin de les sensibiliser à l'observation des détails des œuvres d'art. Lorsque les images sont associées à des variables quantitatives (données), les groupes formés servent de classes pour l'apprentissage supervisé d'un classifieur et la détermination des variables discriminantes. Nous travaillons à compléter cet interface par des techniques d'apprentissage actif, pour aider à la catégorisation interactive de plusieurs milliers d'objets par une délégation progressive de l’homme vers la machine. |

Michaël Aupetit et

Ala Abuthawabeh

Ala Abuthawabeh est post-doctorant dans le groupe Social Computing du Qatar Computing Research Institute de Doha. Michaël Aupetit est Senior Scientist dans le groupe Social Computing du Qatar Computing Research Institute de Doha. |

|

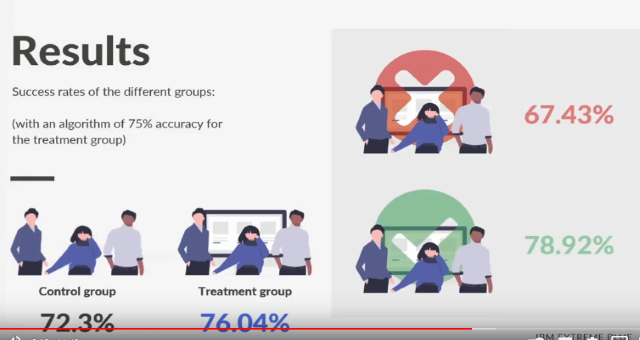

Mesurer la performance et les biais dans la décision métier augmentée

Le BPM organise les flux d’information et de décisions des grandes entreprises. Ces systèmes permettent d’intégrer de l’aide algorithmique à la décision : chaque fois qu’une décision doit être prise, par exemple un achat, un recrutement, une proposition d’offre, une fonction logicielle permet d’émettre une recommandation sur la base des décisions précédentes prises dans le même contexte. Nous nous posons toutefois la question de l’efficacité et l’utilité de cette aide. Peut-on mesurer des améliorations ? Quels biais peuvent intervenir ? Quel est l’effet des modes de présentation ? Pour répondre à ces questions, nous proposons des métriques de performance, biais d’automation et résistance. Nous avons validé l’utilisation de ces mesures dans une étude en ligne. Notre objectif est de fournir une instrumentation appropriée de ces systèmes de recommandation pour assurer la supervision de ce type de système lorsqu’ils sont déployés dans l’entreprise de façon générique. |

Manon Verbockhaven, Guillaume Roy, Victoire Cousergue, Rida Laarach et Thomas Baudel

Ce poster présente les résultats d'un stage d'été IBM ExtremeBlue mené par une équipe de 4 étudiants en Master. Manon Verbockhaven est étudiante à l'INSAE, Guillaume Roy est étudiant à l'ENSAI, Victoire Cousergue est étudiante à Dauphine et Mines ParisTech, Rida Laarach est étudiant à HEC et Telecom ParisTech, Thomas Baudel est directeur de recherche au France Lab d'IBM. |

|

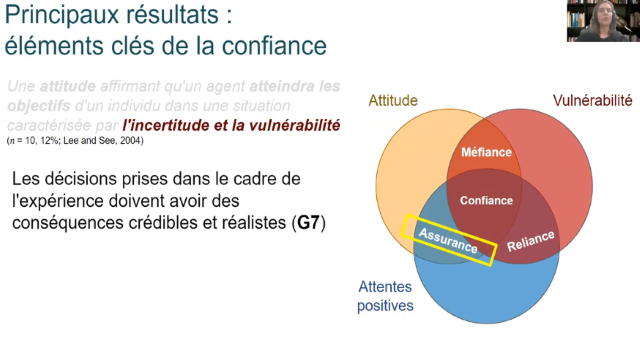

Comment évaluer la confiance dans le contexte de la prise de décision assistée par l'IA?

La propagation des systèmes intégrant l'IA et utilisés dans la prise de décision humaine rend cruciale l'étude de la confiance humaine dans ces systèmes. Cependant, l'étude empirique de la confiance est un défi. L'une des raisons est l'absence de protocoles standard pour concevoir des expériences sur la confiance. Dans cet article, nous présentons une étude des méthodes existantes pour évaluer empiriquement la confiance dans la prise de décision assistée par l'IA et analysons le corpus selon les éléments constitutifs d'un protocole expérimental. Nous constatons que la définition de la confiance n'est pas couramment intégrée dans les protocoles expérimentaux, ce qui peut conduire à des résultats surévalués ou difficiles à interpréter et à comparer d'une étude à l'autre. En nous appuyant sur les pratiques empiriques des études sociales et cognitives sur la confiance humaine-humaine, nous fournissons des guidelines pratiques pour améliorer la méthodologie d'étude de la confiance humaine-IA dans les contextes de prise de décision. En outre, nous proposons deux types d'opportunités de recherche : l'un portant sur l'approfondissement des méthodes de confiance et l'autre sur les facteurs qui ont un impact sur la confiance en l'intelligence artificielle. |

Oleksandra Vereschak, Gilles Bailly et

Baptiste Caramiaux

Oleksandra VERESCHAK est doctorante à Sorbonne Université. Elle s'intéresse principalement à la confiance des utilisateurs dans l'intelligence artificielle (IA), ce qui situe son travail dans le domaine interdisciplinaire de l'Interaction humain-IA. Elle se concentre principalement sur les systèmes intégrant l'IA qui assistent la prise de décision humaine dans les contextes à haut risque tels que la prise de décision médicale, de recrutement et de crédit. Elle étudie non seulement ce qui influence la confiance humaine, mais aussi comment améliorer les protocoles expérimentaux pour l'évaluer en s'appuyant sur sa formation en sciences sociales. Gilles BAILLY est chercheur CNRS à Sorbonne Université. Il travaille dans le domaine de l'Interaction humain-machine. Son sujet de recherche porte principalement sur l'apprentissage et la prise de décision avec les système interactifs. Il développe de nouvelles formes d'interaction s'appuyant sur des technologies robotiques et des modèles du comportement utilisateurs l'appuyant sur l'IA et les sciences cognitives. Baptiste CARAMIAUX est chercheur CNRS à Sorbonne Université. Il mène des recherches interdisciplinaires sur l'apprentissage machine centré sur l'homme, à l'intersection de l'Interaction humain-machine et de l'apprentissage machine. Il s'intéresse particulièrement au contexte de l'interaction incarnée pour les pratiques artistiques et l'acquisition de compétences. |

|

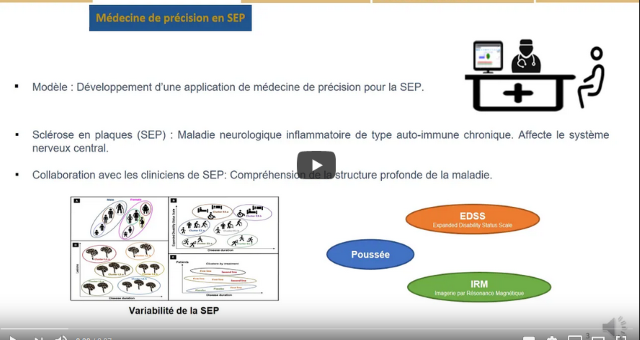

De la prise de décision à la communication avec le patient : mode dual de visualisation pour la gestion de la SEP

Le développement des technologies de l’information a eu un impact majeur dans la prise de décision clinique. Les systèmes informatiques médicaux tirent parti de l’information médicale pour aider les spécialistes en santé dans la prise en charge des patients. C’est une forme de collaboration entre l’humain et la machine pour l’aide à la décision. Dans le cadre d’un projet de thèse, nous essayons d’améliorer cette collaboration en fournissant des modèles d'IHM basés sur des connaissances acquises lors d’observation et d’analyse des pratiques médicales d’un côté, et des possibilités offertes par les bases de données de patients de l’autre. Comme premier modèle, nous avons développé une interface d’interaction homme machine de médecine de précision dans la sclérose en plaques. L’interface développée offre un mode dual de visualisation des résultats obtenus grâce au calculs sur les bases de données de patients. Une vue Patient pour aider le médecin dans sa communication avec le patient (explication sur la maladie, son diagnostic ou les traitements) et une vue Clinicien pour aider à prédire l’état d’évolution de la maladie. |

Chadia Ed-driouch, Cédric Dumas, Franck Mars et Pierre-Antoine Gourraud

Chadia Ed-driouch est doctorante en deuxième année à l’université de Nantes, et travaille en collaboration entre le CHU de Nantes et l’IMT atlantique. Membre de l’équipe PACCE (Perception Action Cognition pour la Conception Ergonomique) du laboratoire des sciences du numérique Nantes (LS2N) et de l’équipe 5 INSERM ATIP-Avenir au sein du CHU de Nantes. Son sujet de thèse porte sur les interactions homme machine pour l’aide au diagnostic médical. Cédric Dumas est enseignant chercheur à l'IMT Atlantique, et membre de l'équipe PACCE (Perception Action Cognition pour la Conception Ergonomique) du laboratoire des sciences du numérique Nantes (LS2N). Il travaille sur la collaboration humain-machine, principalement dans le domaine des technologies médicales. Franck Mars est directeur de recherche CNRS, responsable de l'équipe PACCE (Perception Action Cognition pour la Conception Ergonomique) du LS2N. Spécialiste en ergonomie cognitive, il s'intéresse à la conception de système techniques basés sur la compréhension du fonctionnement humain, avec un focus sur les processus de la perception, moteur et leurs interactions avec les processus cognitifs de haut niveau. Pierre-Antoine Gourraud est professeur des universités, praticien-hospitalier de la faculté de médecine de l’université de Nantes (France). Responsable de l'équipe 5 ATIP-AVENIR INSERM (Immunogénomique Translationnelle en Transplantation et Autoimmunité). Coordinateur de la "clinique de données" qui réunit le groupe d'épidémiologie clinique du CIC et les experts de l'Unité de santé publique et d'épidémiologie (PHU11). Ses activités de recherche se positionnent au carrefour de l'immunologie, de la génétique et du traitement informatique des données de santé. |

|

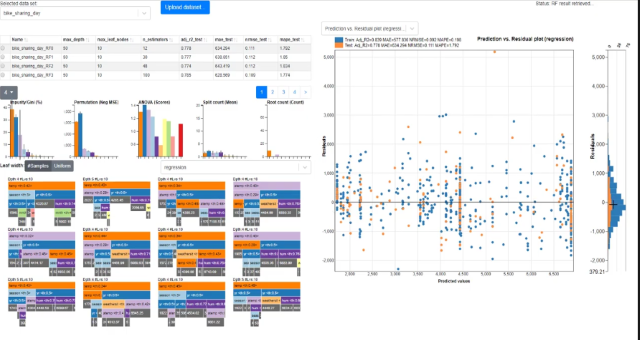

Exploration visuelle de forêts aléatoires

Les acteurs industriels, économiques et sociaux portent un intérêt croissant envers les algorithmes d’apprentissage. Parmi les algorithmes plus efficaces, les forêts aléatoires sont constituées d’un ensemble d’arbres de décision appris à partir d’échantillons tirés aléatoirement dans un jeu de données d’entraînement. La multiplication des sous-modèles induits (arbres de décision) complique l’interprétation des forêts aléatoires. Or, l’explicabilité des modèles d’apprentissage est essentielle à leur adoption car elle contribue à la confiance à leur égard. Nous présentons ici un travail en cours sous la forme d’une démonstration d’un logiciel de visualisation analytique permettant d’explorer des forêts aléatoires. Une interface composée de vues multiples et coordonnées permet d’analyser leur performance et leur comportement, d’un point de vue global sur un ensemble de forêts et d’un point de vue local, pour une prédiction, une sélection de données ou une règle de décision particulière. L’objectif est de rendre ces modèles plus transparents en explicitant leur structure interne et en la mettant en relation avec les données d’entraînement et de test, et aussi les variables d’entrée et les prédictions fournies en sortie. Les règles de décision constituant les arbres recèlent beaucoup d’informations utiles qui justifient une prédiction. Pour une prédiction donnée, il est intéressant d’analyser comment chaque règle de décision contribue à la prédiction globale, et les (dés-)accords entre les arbres. En outre, l’accès aux données d’entraînement utilisées pour construire chaque règle permet de les analyser suivant différentes perspectives, par exemple en montrant leur dispersion sur les domaines des valeurs réelles et prédites ou encore en affichant l’étendue de leur erreur résiduelle. L’un des défis que nous souhaitons aborder à l’avenir consiste à réorganiser ou résumer les ensembles d’arbres pour mieux révéler les règles dominantes. Nous souhaitons aussi proposer des visualisations permettant de contextualiser la structure du modèle en explorant l’espace des données d’apprentissage. |

Nicolas Médoc et Mohammad Ghoniem

Nicolas Médoc is a Research and Technology Associate at Luxembourg Institute of Science and Technology (LIST). He has been with LIST since 2008. He is currently a member of the Data Science and Analytics (DSA) research unit of the Information Technology for Innovative Services (ITIS) Department. He received his Ph.D. in Computer Science, from the University of Paris, France, in 2017. His research interests include visual analytics, co-clustering, topic models and machine learning and their applications. Mohammad Ghoniem is a Senior Research and Technology Associate at LIST. He has been with LIST since 2013. He is currently a member of the DSA unit of the ITIS Department. He holds a Ph.D. in Computer Science, from the University of Nantes (2005), and a Diplôme d’Ingénieur from Ecole des Mines de Nantes (2000). His main research interests include data visualization, visual analytics, explainable AI and their applications. |

|

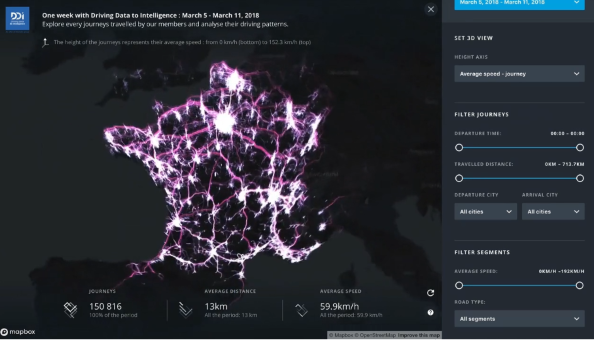

Dataveyes, Pour une intelligence artificielle éclairée par le design

L’ère des données riches, de l'intelligence artificielle (IA) et des objets connectés bouleverse les usages. Nous voulons prendre part à cette révolution des interactions humains-données-algorithmes. Pour cela, construisons des solutions aux problèmes d'information et d'utilisation posés par la massification des données et la complexité des algorithmes. Nous concevons et nous réalisons des interfaces et des outils, pour rendre les algorithmes d'IA auditables et appréhendables, et pour rendre les humains capabes de s'informer, de travailler et de vivre avec les données. Nos projets rendent les données éclairantes et valorisent les usages des technologies d'IA. Ils traduisent notre vision : placer l'humain au coeur de l'écosystème des données amplifié par l'IA. Nous aidons les organisation à innover dans ce domaine, grâce à notre expertise en visualisation de données, en développement de systèmes complexes, et en design d'information appliqué aux données. Nos méthodes sont inspirées du design thinking et des méthodes agiles. Nous les pratiquons en gardant toujours nos yeux rivés sur l'utilisateur final, et nos mains dans les données réelles. |

Dataveyes

La vidéo est une production collective de l'équipe Dataveyes. Ont travaillé sur ce projet les designers et développeurs de Dataveyes en 2020 : Ludovic Riffault, Antoine Venco, Nicolas Forestier, Florian Boudot, Benoît Lucet, Léo Gourven, Benoit Vidal, Caroline Goulard. |

Le bilan interne de la journée est disponible ici.

La vidéo complète: